この記事は、YouTubeでもご覧いただけます。映像とナレーションで内容がよりわかりやすく解説されているので、ぜひ以下のリンクからご覧ください。

■【競馬予想AIを学ぶ】KerasによるAI競馬予想(二値分類)

https://youtu.be/yTaK08l0UWc

この記事を読む前に「Kerasで実現するディープラーニングによるAI競馬予想(準備編)」の記事を先に読んでください。その中には、機械学習の基礎知識や、学習データで使う説明変数の内容など、他のデータ分析方法と共通する説明が含まれています。

二値分類(binary)

「二値分類」は目的変数を0か1の二値に分類する方法です。

ここに公開するPythonのソースコードは「正解率・適合率・再現率・F値・AUC」の評価指標を計算する機能を実装しています。学習データを作るSQLで目的変数の項目名を「target」にすれば、オリジナルの学習データで分析する場合でもそのまま使えます。

ソースコードは学習用と予測用に分けてます。

欠損値(null)は、SQLで何らかの値(0など)に変換しておくことを前提にしてます。欠損値についてPythonでは何もしてないってことです。

学習用ソースコード

以下が「二値分類」で学習するPythonのソースコードです。この学習用ソースコードのファイル名は「dl_binary_train.py」とします。

PythonのソースコードはUTF-8で保存する必要があります。何のこっちゃ分からん場合は、このページの最後の、有料会員限定のダウンロードリンクからもファイルをダウンロードできます。

ソースコードはQiitaの記事から簡単にコピーできます。

※ソースコードの右上に出るアイコンをクリックしてください。

https://qiita.com/PC-KEIBA/items/5ec8d61867e7d1935c5b

import joblib

import numpy as np

import pandas as pd

from keras.layers import Dense, Dropout

from keras.models import Sequential

from sklearn.metrics import classification_report, roc_auc_score

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# CSVファイル読み込み

in_file_name = 'dl_binary_train.csv'

df = pd.read_csv(in_file_name, encoding='SHIFT_JIS')

# 説明変数(x)と目的変数(y)を設定

target = 'target'

x = df.drop(target, axis=1)

y = df[target]

# 訓練データとテストデータを分割

x_train, x_test, y_train, y_test = train_test_split(x, y, test_size=0.2, random_state=42)

# 特徴量の標準化

scaler = StandardScaler()

x_train = scaler.fit_transform(x_train)

x_test = scaler.transform(x_test)

# スケーラーを保存

joblib.dump(scaler, 'binary_scaler.joblib')

# モデルの構築

model = Sequential()

model.add(Dense(128, input_dim=x_train.shape[1], activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(64, activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(1, activation='sigmoid'))

# モデルのコンパイル

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# モデルの学習

model.fit(x_train, y_train, epochs=50, batch_size=32, validation_data=(x_test, y_test))

# モデルをファイルに保存

model.save('binary_model.h5')

# 評価指標

loss, accuracy = model.evaluate(x_test, y_test)

# 正解率、適合率、再現率、F1

y_probs = model.predict(x_test)

y_pred = (y_probs > 0.5).astype(int)

# AUC

auc = roc_auc_score(y_test, y_probs)

print(f'正解率 = {accuracy:.4f}')

print(f'AUC = {auc:.4f}')

print(classification_report(y_test, y_pred))このソースコードは、netkeibaが主催する予想大会の「俺プロ」で、最強位に昇り詰めた管理人@PC-KEIBAが実際に使用しているものです。その中で「最強位」とは、参加者の上位約10%のみが取得できる名誉ある称号で、競馬予想の実力を証明しています。

学習データを作る

説明変数は他の分析方法と共通にしました。内容は「Kerasで実現するディープラーニングによるAI競馬予想(準備編)」の記事を見てください。学習データのファイル名は「dl_binary_train.csv」とします。

今回のサンプルでは目的変数の「確定着順」を、次のように分類してみます。

- 3着以内→1

- 上記以外→0

このページの最後に、サンプルのSQLを有料会員に公開しています。ユーザーがカスタマイズして利用することも可能ですし、SQLを学習したい方の参考にもなります。

Kerasに学習させる

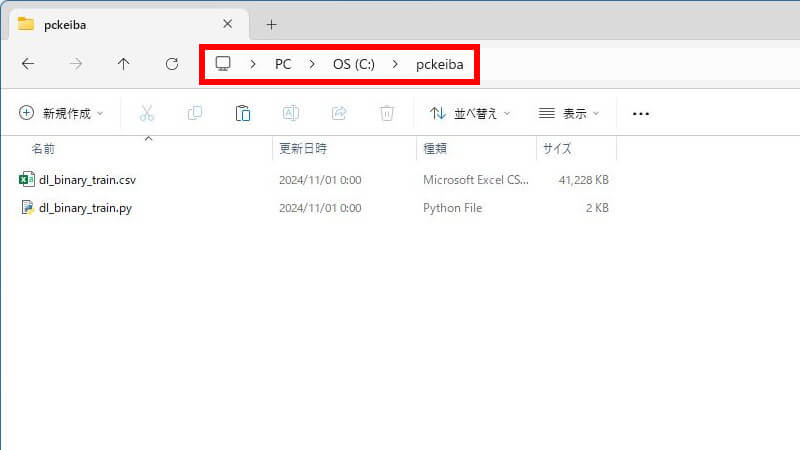

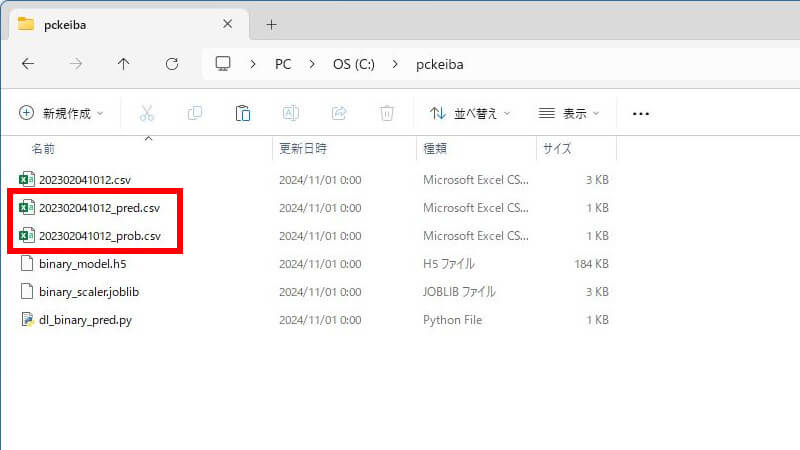

今回の例では、Cドライブの直下に「pckeiba」というフォルダを作って、

- 学習データ(dl_binary_train.csv)

- 学習用ソースコード(dl_binary_train.py)

2つのファイルを置きます。こういう状態です。

そして、コマンドプロンプトを起動し、次の2つのコマンドを「1行ずつ」実行してください。

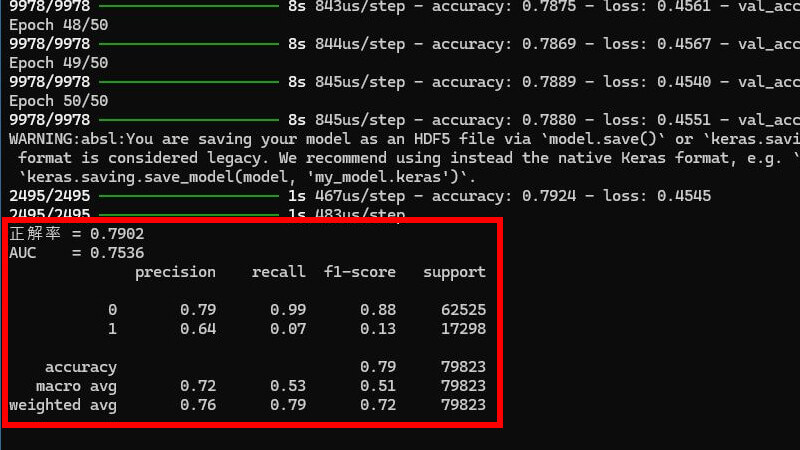

cd C:\pckeibapython dl_binary_train.pyKerasが学習を開始します。処理が終わると評価指標を表示します。

モデルを評価する

今回のサンプルでは、次の3つの評価指標を表示します。

- 「正解率」= 全てのサンプルを正解した割合

- 「適合率」= 1と予測したサンプルのうち、実際に1であった割合

- 「再現率」= 実際に1であるサンプルのうち、1と予測した割合

- 「F値」= 適合率と再現率の調和平均を表す指標

- 「AUC」= ROC曲線の下の面積を示し、1に近いほど分類精度が高い

正解率がやたら高いですが、これは実際の0が圧倒的に多いため、その影響が大きくなっています。そのため、正解率だけで判断するのは誤りです。今回のデータ分析では、適合率と再現率を主な指標として用いることが適切だと考えます。

これを競馬場や距離などレースの条件ごとに分析したら、もっと精度の高いモデルに出来るかもしれません。二値分類の評価指標は、この他にもあるのでググって研究してください。

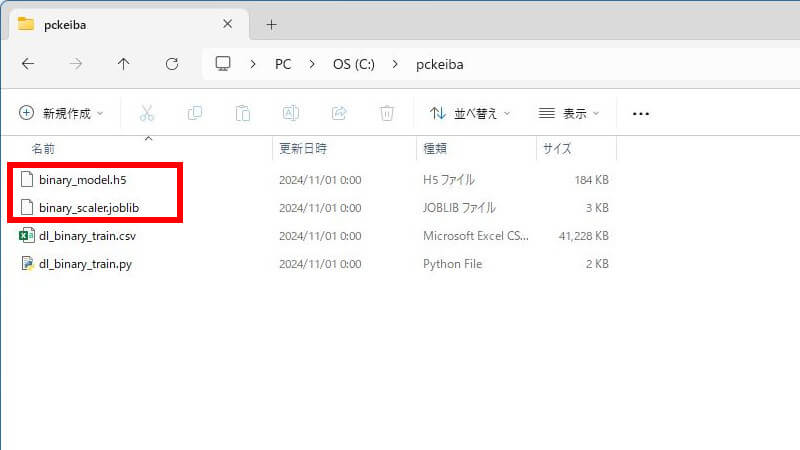

このモデルを「binary_model.h5」に、スケーラーを「binary_scaler.joblib」に保存しています。このファイルは予想するとき使います。

これを使って明日のレースを予想させます。

予測用ソースコード

以下が「二値分類」で予想するPythonのソースコードです。

PythonのソースコードはUTF-8で保存する必要があります。何のこっちゃ分からん場合は、このページの最後の、有料会員限定のダウンロードリンクからもファイルをダウンロードできます。

ソースコードはQiitaの記事から簡単にコピーできます。

※ソースコードの右上に出るアイコンをクリックしてください。

https://qiita.com/PC-KEIBA/items/5ec8d61867e7d1935c5b

import joblib

import numpy as np

import pandas as pd

import os

import sys

from keras.models import load_model

# 出馬表ファイル読み込み

fname = sys.argv[1]

x_test = np.loadtxt(fname, delimiter=',', skiprows=1)

# 1行だけの場合でも2次元配列に変換

if x_test.ndim == 1:

x_test = x_test.reshape(1, -1)

# モデル読み込み

model = load_model('binary_model.h5')

scaler = joblib.load('binary_scaler.joblib')

# 特徴量の標準化

scaled = scaler.transform(x_test)

# データの予測

y_probs = model.predict(scaled)

y_pred = (y_probs > 0.5).astype(int)

# 拡張子を除いたファイル名を取得

fname = os.path.splitext(os.path.basename(fname))[0]

# 予測値を出力

df = pd.DataFrame(y_pred, columns=['予測値'])

df.to_csv(fname + '_pred.csv', encoding='SHIFT_JIS', index=False)

# 予測確率を出力

df = pd.DataFrame(y_probs, columns=['確率'])

df.to_csv(fname + '_prob.csv', encoding='SHIFT_JIS', index=False)出馬表データを作る

予測させる出馬表データは、学習データ作成のSQLと出力後のファイルを少し改造すれば作れます。学習データとの違いは次の2つです。

- SQLで目的変数「target」の項目を消す。

- SQLで予想するレースでレコードの抽出条件を設定する。

出馬表データのファイル名は何でも良いですが、ここでは「レースID(※1).csv」とします。

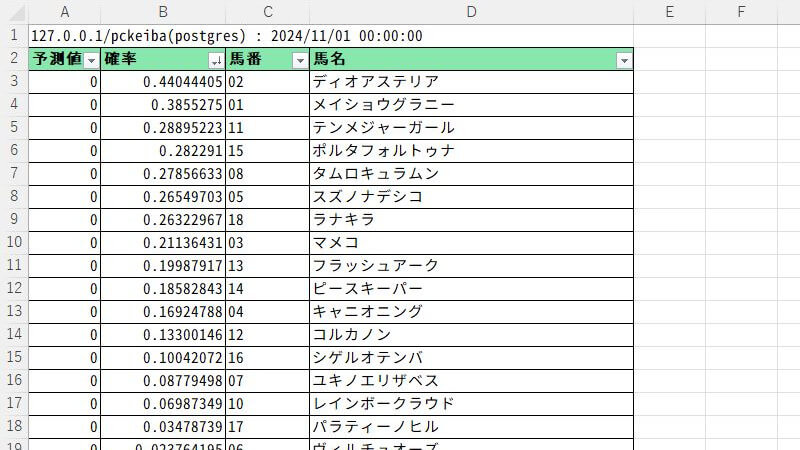

今回のサンプルでは「2023/02/04(土)小倉12R」を予想してみます。

| (※1)レースID | 年月日場R yyyymmddjjrr(12桁) |

|---|

このページの最後に、サンプルのSQLを有料会員に公開しています。ユーザーがカスタマイズして利用することも可能ですし、SQLを学習したい方の参考にもなります。

予測(予想)させる

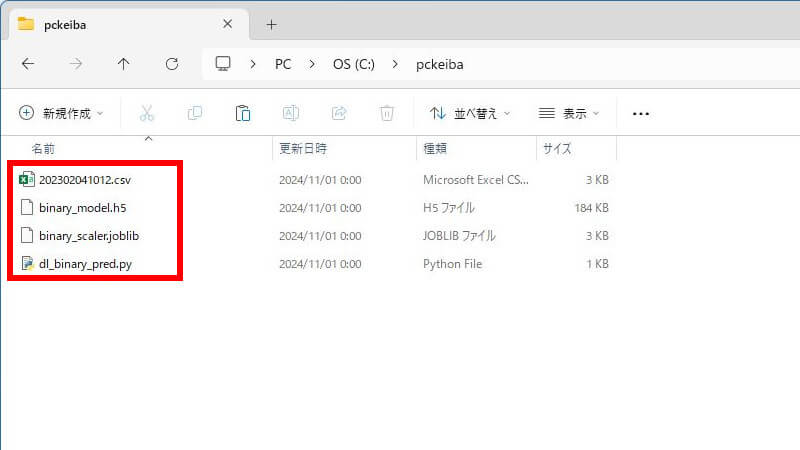

先ほどと同じ「pckeiba」というフォルダに、

- 出馬表(レースID(※1).csv)

- モデル(binary_model.h5)

- スケーラー(binary_scaler.joblib)

- 予測用ソースコード(dl_binary_pred.py)

3つのファイルを置きます。こういう状態です。

そして、コマンドプロンプトを起動し、次の2つのコマンドを「1行ずつ」実行してください。2番目は、予測用ソースコードの後に、半角スペースと出馬表のファイル名です。

cd C:\pckeibapython dl_binary_pred.py 202302041012.csv処理が終わると2つのファイルが出力されます。「予測値」と「確率」のファイルです。

- レースID(※1)_pred.csv (予測値)

- レースID(※1)_prob.csv (確率)

このファイルには数値データしか含まれていないので、分かりにくいかもしれませんが、出馬表データと同じ馬番の昇順で出力されます。馬券を買うときは、SQLで馬番と馬名だけの出馬表をCSVに出力して、そこへ貼り付けて確率で並べ替えると便利です。例えば、こんな感じです。

「二値分類」による競馬予想AIの話は以上です。

今回のサンプルはあくまで1つの「サンプル」でしかありません。完成させるのはユーザーのあなたです。